|

|

Центр коллективного пользования "Суперкомпьютерный центр ОИВТ РАН"

Общие сведения

Центр коллективного пользования (ЦКП) "Суперкомпьютерный Центр ОИВТ РАН" был создан в 2016 году на базе информационно-вычислительного центра ОИВТ РАН. Руководителем ЦКП является Левашов Павел Ремирович, специалист в области вычислительной физики. Основной целью ЦКП является предоставление высокопроизводительных вычислительных ресурсов учреждениям, подведомственным ФАНО России и иным организациям, для проведения фундаментальных и прикладных научных исследований. ЦКП предназначен для решения следующих задач:

В 2018 году Cуперкомпьютер ОИВТ РАН «Десмос» вошел в топ-50 суперкомпьютеров России и стран СНГ

Контактная информация

Адрес: 125412, г. Москва, ул. Ижорская, д.13, стр.2, Объединенный институт высоких температур РАН

Телефон: +7(495)4842456 Электронная почта: scc@jiht.ru Документы ЦКП

Перечень оборудования

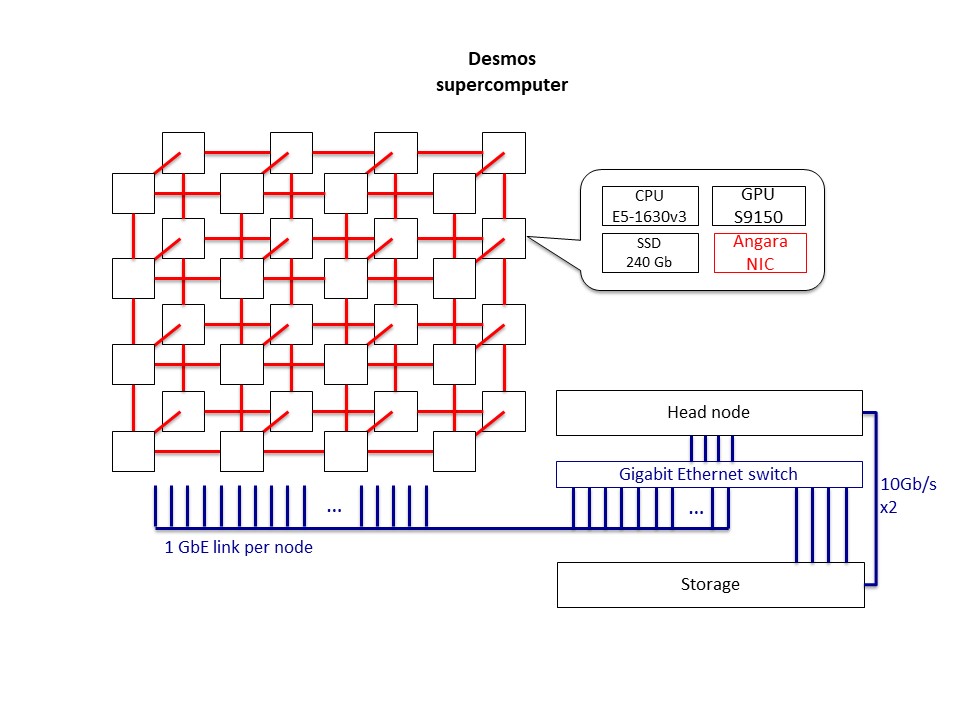

Суперкомпьютер "Десмос"

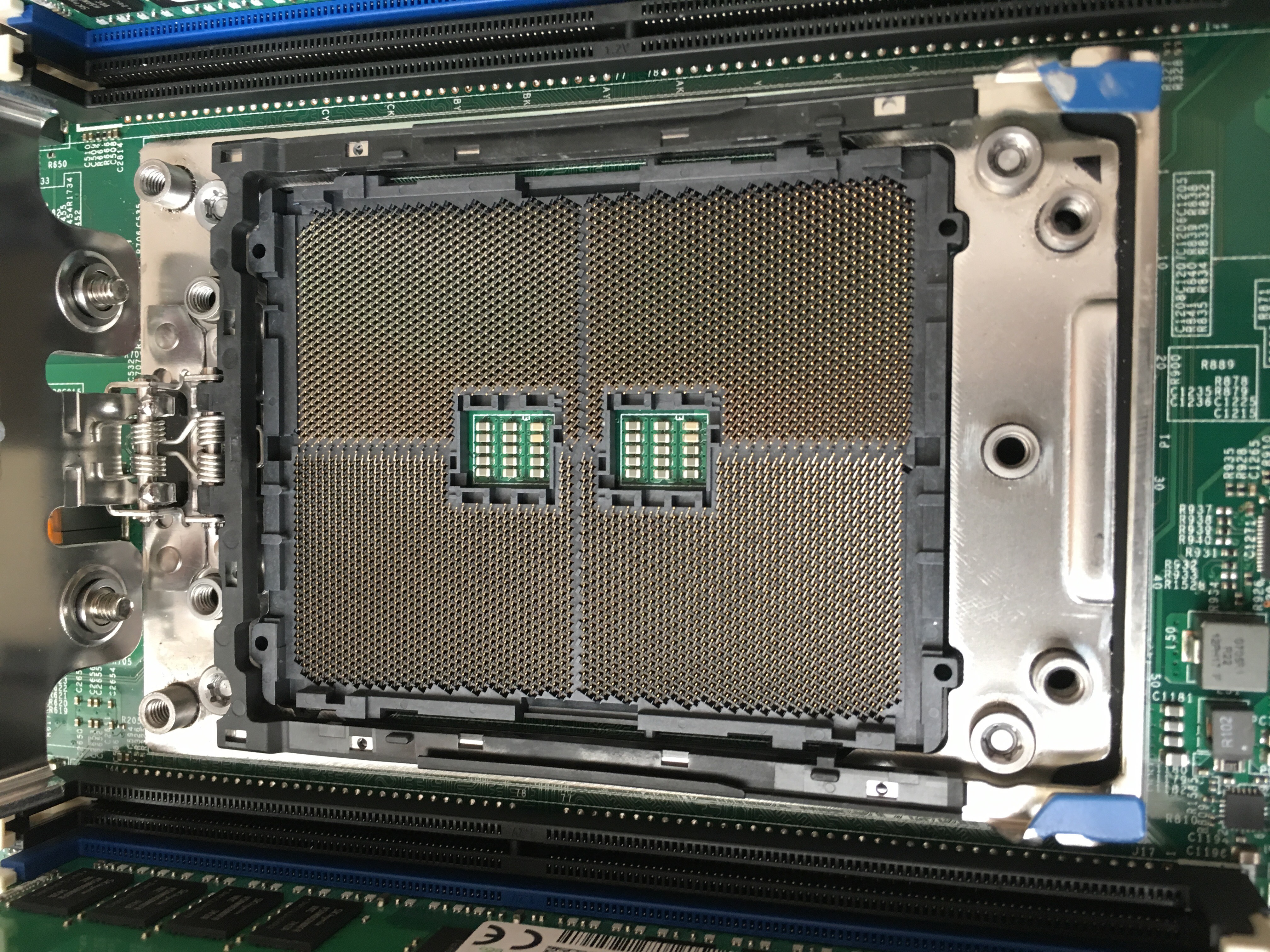

Суперкомпьютер состоит из 32 вычислительных узлов и одного головного. Конфигурация вычислительного узла:

Узлы соединены с помощью интерконнекта Ангара и Gigabit Ethernet. Текущей топологией суперкомпьютера является 4D-тор 4 х 2 х 2 х 2 (X х Y х Z х K), но каждый узел по осям Y, Z, K соединен с другим лишь одним линком. Также в составе суперкомпьютера имеется идентичный по конфигурации головной узел, соединенный с остальными узлами с помощью Gigabit Ethernet.

Суперкомпьютер работает под управлением ОС SLES 11 SP4 с библиотекой Angara MPI, которая базируется на MPICH 3.0.4. Интерконнект Ангара — это спроектированная в России коммуникационная сеть тороидальной топологии. СБИС адаптеров был разработан в АО “НИЦЭВТ” и произведен компанией TSMC по технологическому процессу 65 нм. Архитектура Ангары использует принципы, аналогичные тороидальным интерконнектам IBM Blue Gene L/P и Cray Seastar2/Seastar2+. Тороидальный интерконнект, созданный EXTOLL, также имеет общие черты с Ангарой. Чип Ангары поддерживает deadlockfree адаптивную маршрутизацию, направленно-упорядоченную маршрутизацию, а также методы для повышения отказоустойчивости. Каждый узел имеет выделенную область в памяти, доступную для удаленного доступа с других узлов (поддерживаются атомарные и read/write операции), что обеспечивает поддержку языков OpenSHMEM и PGAS. Для MPP-программной модели имеется поддержка MPI и OpenMP. Сетевой адаптер представляет собой плату PCI Express, которая может быть использована для соединения с соседними узлами с возможностью подключения 6 кабелей (или 8 кабелей при использовании платы расширения). Поддерживаемыми топологиями в данном случае являются кольцо, двумерный, трехмерный и четырехмерный торы. Суперкомпьютер "Фишер"

Вычислительный кластер состоит из 18 узлов и одного головного. 17 узлов имеют конфигурацию:

16 подобных узлов объединены Infiniband FDR. 1 узел имеет конфигурацию:

Кластер вычислительный в комплекте с системой жидкостного охлаждения был поставлен в ОИВТ РАН в 2018 году на средства РНФ. На кластере проводились расчеты по атомистическому моделированию методом Монте-Карло и молекулярной динамики, а также континуальному моделированию гидродинамических и магнитно-гидродинамических задач. Кроме того, на кластере настроено программное обеспечение для проведения расчетов в GRID-системах. Кластер состоит из 13 вычислительных узлов, имеющих следующие характеристики: 2 процессора Intel Xeon 3.0 ГГц, 2 Гб оперативной памяти на узел, жесткий диск на 160 Гб, сетевые интерфейсы Fast Ethernet и Gigabit Ethernet. Производительность кластера на тесте LINPACK составляет 108 Гфлопс.

Сведения о календарной загрузке оборудования

Перечень оказываемых типовых услуг

Услуги, оказываемые ЦКП:

Оказание Услуг осуществляется в соответствии с действующими законами и локальными нормативными актами. Результатом оказания Услуг являются новые знания, а именно, экспериментальные данные в научно-исследовательских работах, параметрические характеристики в технологических работах, методические рекомендации в методических работах, а также сертификаты обучения в учебных работах. Подробный перечень услуг можно найти в Регламенте Центра коллективного пользования "Суперкомпьютерный центр ОИВТ РАН" по оказанию услуг внешним пользователям для научно-исследовательских, технологических и учебных целей. Регламент доступа к оборудованию

Проект договора на выполнение работ и оказания услуг для проведения научных исследованийФорма заявки на выполнение работ и оказание услуг для проведения научных исследований

Форму заявки на выполнение работ и оказание услуг для проведения научных исследований можно скачать здесь.

Исчерпывающий перечень причин отклонения заявокПорядок расчета стоимости нестандартных услугПеречень имеющихся методик/СОП/методов выполнения измерений

Методик/СОП/методов выполнения измерений не предусмотрено.

План работы ЦКПОтчеты по ЦКП |